Last updated on 13 décembre 2024

Avant toute chose je tiens à rappeler que je suis physicien « numéricien » de formation1C’est à dire que je considère que je fais essentiellement de la physique avec des calculs sur ordinateur plus que de la théorie ou du travail expérimental. Yes, sadly, we exist. et ni philosophe de l’esprit, ni chercheur en Machine Learning (ML). Cependant le ML a gagné tellement en efficacité et en popularité qu’il est difficile de ne pas suivre ce qui s’y fait et de s’y intéresser dans beaucoup de branches de la recherche. De plus, s’il y a bien un sujet de philosophie qui m’intéresse c’est l’épistémologie des sciences et la question de la compréhension individuelle n’en est vraiment pas loin. Ces précisions de nouveau faites, allons-y.

1. L’article de la chambre chinoise

1.1 À quoi répond Searle

Il convient tout d’abord de renvoyer les lecteurs et lectrices à la vidéo de MrPhi qui a suscité ce billet et vous la trouverez donc ici. Je tiens en particulier à revenir sur la présentation de l’expérience de la chambre chinoise, le fait qu’elle soit soit-disant « discutée », et ce à quoi elle visait initialement à répondre. Il est par ailleurs très intéressant d’aller lire l’article original de Searle ainsi que les réponses qu’il a suscité à sa publication, article disponible ici, contenant les commentaires de pas moins de 28(!) collègues ainsi que la réponse de Searle à ces commentaires. Je vous déconseille évidemment de le télécharger sur des sites de piratages tels que Sci-hub où on peut également le trouver illégalement.

Un rapide coup d’œil à l’abstract permet tout d’abord de comprendre à quoi Searle répond spécifiquement: à la position qu’il qualifie « d’IA forte » défendant:

- le fait qu’une IA comprenne les histoires qui lui sont racontées (l’exemple pris est un programme visant à simuler la compréhension d’histoires abstraites) et fournit des réponses parce qu’elle les comprend.

- le fait que ces états mentaux ne soient pas des modèles pour expliquer les processus cognitifs mais bien des processus cognitifs en eux-même. Une « IA forte » aurait donc des états mentaux, et donc, un « esprit ».2Si on limite la définition d’esprit au fait d’avoir des états mentaux du coup.

Searle n’a pas ailleurs aucun problème à considérer les IA comme des modèles d’esprit pour tester des hypothèses sur les fonctionnement cognitifs, ce qu’il a appelle la position « IA faible ». Là où il est en désaccord c’est avec les deux points avec lesquels il définit l’argument de l’IA forte.

Un point important dans l’argument de Searle, et étonnamment passé sous silence dans la présentation de MrPhi, est qu’il compare l’application des opération de production d’une réponse en chinois par l’opérateur aux facultés cognitives mobilisées lorsqu’il fait la même chose en anglais.3L’anglais est la langue natale de Searle, mais l’idée se transpose facilement à n’importe quelle langue que parlerait l’opérateur de la chambre. Il note bien qu’il mobilise des ressources cognitives différentes de celles utilisées pour les réponses chinoises lorsqu’il veut produire une réponse en anglais, puisqu’il comprend les questions qui lui sont posées. Par ailleurs, et l’argument est aussi intéressant ici, il n’est jamais prouvé que les ressources qu’il mobilise pour parler anglais sont assimilables aux méthodes qui lui sont données pour répondre en chinois, ces dernière étant de plus extérieures à lui. Et alors qu’il a demandé les implications de cette différence à des défenseurs de la position « IA forte », plusieurs réponses différentes lui ont été données sans réel consensus.

Il est intéressant enfin de noter que, selon Mr Phi, la majorité des philosophes et des philosophes de l’esprit resteraient fonctionnalistes au motif que les arguments de Searle et Block ne seraient pas convaincants. La recherche scientifique et l’évolution des idées ne fonctionnent cependant pas à des appels à la popularité et ces derniers ne garantissent pas la véricité ou la fécondité d’une hypothèse ou d’une théorie.4Une idée qui n’a rien de fantastique aujourd’hui. Lisez par exemple Thomas Kuhn, Feyerabend, Polanyi ou allez voir nos lectures d’Alan Chalmers avec CNQT sur la chaîne Youtube du collectif ZEM. De plus il s’agit d’une pétition de principe. De la même manière, on pourrait très bien dire que les expériences d’Alain Aspect ne sont pas convaincantes puisque beaucoup de philosophes du sondage défendent aussi les variables cachées en mécanique quantique. Donc de la même manière que la survie du fonctionalisme sous-entendrait qu’il y a « un truc qui cloche » dans l’argument de la chambre chinoise, peut-être que le fait que la chambre chinoise interpelle montre qu’il y a un truc qui cloche dans le fait d’assumer que les machines ont des états mentaux et donc que la conclusion fonctionaliste est qu’elles comprennent les entrées qu’on leur fourni.

1.2 Les angles morts du fonctionnalisme que pointe Searle: le retour du dualisme et la projection de l’intention

Ceci étant, dit Searle soulève une des conséquences un peu gênantes de l’application du fonctionalisme au cas des machines en particulier, mais surtout du fait de considérer que des programmes, indépendamment de leur support, définissent des états mentaux: la nécessité d’un dualisme corps-esprit (ou au moins cerveau-esprit). En effet, si on considère que les états mentaux peuvent être générés indépendamment de leur support (cerveau ou mémoire d’ordinateur), cela suppose qu’il existe un élément indépendant du cerveau dans la génération de la conscience. Dit autrement, si on considère que les états mentaux entre les machines et les cerveaux peuvent être strictement équivalents, alors on considère que l’esprit est quelque chose d’indépendant du cerveau. Et c’est une conclusion étonnante de la thèse de la réalisabilité multiple (que ne mentionne pas MrPhi quand il en parle) qui coince un peu avec les courants matérialistes.5Notons d’ailleurs que le problème n’est pas, contrairement à ce qu’il dit aussi dans sa vidéo, qu’on puisse implémenter les mêmes fonctions sur différents supports, mais ce que cela implique si on limite l’esprit aux états mentaux, et les états mentaux aux dites fonctions. Mais je digresse.

Enfin l’argument que Searle met en avant pour résoudre la tension que créée son argument est l’existence de l’intentionnalité. En effet, c’est pour illustrer ce point qu’il compare sa production d’une réponse en anglais et d’une réponse en chinois dans la chambre chinoise. Comme il le dit lui-même:

Because the formal symbol manipulations by themselves don’t have any intentionality; they are quite meaningless; they aren’t even symbol manipulations, since the symbols don’t symbolize anything. In the linguistic jargon, they have only a syntax but no semantics. Such intentionality as computers appear to have is solely in the minds of those who program them and those who use them, those who send in the

John R Searle, Minds Brains and Programs

input and those who interpret the output. The aim of the Chinese room example was to try to show this by showing that as soon as we put something into the system that really does have intentionality (a man), and we program him with the formal program, you can see that the formal program carries no additional intentionality. It adds nothing, for example, to a man’s ability to understand Chinese.6Comme la manipulation de symboles formels ne contient aucune forme d’intentionnalité; elle n’a pas beaucoup de sens; il ne s’agit même pas de manipulation de symboles puisque les symboles ne symbolisent rien. En jargon linguistique, ils ont une syntaxe mais pas de sémantique. Ce genre d’intentionnalité que les ordinateurs donnent l’impression d’avoir n’est que le produit de l’esprit de celles et ceux qui les programment et les utilisent, celles et ceux qui leur donnent des entrées et interprètent les sorties. L’argument de la chambre chinoise voulait démontrer ceci en illustrant comment dès que l’on introduit dans le système un élément avec une intentionnalité (un humain), et qu’on le programme avec un programme formel, on constate que le programme formel n’apporte aucune intentionnalité supplémentaire. Il n’ajoute rien, par exemple, à la capacité de l’individu à comprendre le chinois.

L’argument de Searle est double. D’une part que la manipulation de symboles ne suffit pas à définir la compréhension, mais ça on l’avait compris, d’autre part, que si on a l’impression de trouver de l’intentionnalité et du sens7L’intentionnalité étant dans le fait d’obtenir une réponse volontairement donnée à une question posée. dans les relations entrées/sorties des programmes, c’est parce que l’on en met nous-même, de la même manière qu’on considère qu’une porte automatique « sait » quand s’ouvrir quand son capteur photoélectrique est correctement stimulé. Et « intentionnalité » est probablement le mot le plus important de l’article. Et on sent même bien que c’est un point d’achoppement car c’est non seulement un des mots les plus récurrents dans l’article (une cinquantaine d’occurrences) mais aussi dans les réponses publiées. Ce point n’est pas ailleurs pas non plus abordés par MrPhi.

Je terminerai juste en signalant que la différence entre les différentes définition de « comprendre » était déjà adressée par Searle. Comme il le dit dans son article:

But first I want to block some common misunderstandings about « understanding »: in many of these discussions one finds a lot of fancy footwork about the word « understanding. » My critics point out that there are many different degrees of understanding; that « understanding » is not a simple two-place predicate; that there are even different kinds and levels of understanding […] To all of these points I want to say: of course, of course. But they have nothing to do with the points at issue. There are clear cases in which « understanding » literally applies and clear cases in which it does not apply; and these two sorts of cases are all I need for this argument. I understand stories in English; to a lesser degree I can understand stories in French; to a still lesser degree, stories in German; and in Chinese, not at all. My car and my adding machine, on the other hand, understand nothing: they are not in that line of business.8Je voudrais d’abord clarifier certaines mécompréhensions sur ce que veut dire « comprendre » ici: dans de nombreuses discussions, beaucoup tournent autour du pot quand au sens de « comprendre ». Mes critiques pointent du doigt qu’il existe plusieurs degrés de compréhension, que la « compréhension » n’est pas un simple prédicat binaire, qu’il y a différentes formes de compréhension […] À toutes ces remarques je souhaite répondre: bien sûr, bien sûr. Mais elles sont hors de propos ici. Il y a des situations claires dans lesquelles le mot « comprendre » s’applique sans ambiguïté et des situations claires où il ne s’applique pas. Et ces deux types de situations sont les seules dont j’ai besoin pour mon argument. Je comprend des histoires racontées en anglais, je comprend moins celles racontées en français, encore moins celles racontées en allemand, et aucunement celles racontées en chinois. Ma voiture et ma calculatrice, de leur coté, ne comprennent rien: elles n’ont rien à faire dans cette catégorie.

John R Searle, Minds Brains and Programs

En un sens Searle répond déjà à la considération du découpage compréhension objective/subjective en expliquant clairement que la simple capacité à réaliser une tâche ne sous-entend rien à l’existence d’une « compréhension » de la tache. Ma voiture n’a pas d’image mentale de la route ou du fait de tourner quand je tourne son volant. La porte automatique n’a pas d’image mentale des individus qui veulent la franchir.

La compréhension « Objective »

2.1 Sur les descriptions « objectives », une critique de Michael Polanyi

Dans son livre « Meaning » de 1976, le philosophe Michael Polanyi s’étend sur les explications « objectives » du comportement en termes de processus physico-chimiques, des tentatives notamment défendues par les behavioristes. Comme il le dit lui-même:

The philosophy of behaviorism does not contest the duality of body and mind, but it assumes that all mental performances can be fully specified without referring to any mental motives. […] In Personal Knowledge I have described how the behaviorist psychology of learning is able to achieve plausibility.4 It does so first by limiting the inquiry to the crudest forms of learning. These much simplified cases can then be plausibly described in objectivist terms. Even so, they can be shown to apply to the actual process of learning only because their meaning is tacitly understood by their bearing on the mental events covertly kept in mind. […] Noam Chomsky’s critique of B. F. Skinner’s Verbal Behavior presents many illustrations of such behaviorist paraphrasing. Apparently objective terms, like « stimulus, » « control, » « response, » and so on, are so used that their ambiguity covers the mental terms they are supposed to replace. Chomsky shows that either you use these objectivist terms literally—and then what is said is obviously false and absurd—or you use them as substitutes for the terms they are supposed to eliminate—and then you do not say anything else than what you would have said in mental terms. The same criticism applies to the mechanical simulation of tacit knowing. A tacit integration can be only superfically paraphrased by a computer, and such paraphrases succeed by evoking the mental qualities which they claim to enact.9La philosophie behavioriste ne conteste pas la dualité du corps et de l’esprit, mais affirme que tous les processus mentaux peuvent être compris sans se réferrer aux motivations mentales. […] Dans Personal Knowledge j’ai décris comment la description béhavioriste de l’apprentissage arrive à paraitre plausible. C’est parce qu’elle limite ses intérêts aux formes d’apprentissage les plus basiques. Ces cas très simples peuvent être décrits en termes objéctivistes. Mais même dans ce cas, ils ne peuvent être ramenés au processus effectif d’apprentissage uniquement parce que leur sens est compris tacitement via leur support par les événements mentaux qui prennent secrêtement place dans l’esprit […] La critique de Verbal Behavior de B.F. Skinner par Noam Chomsky présentent de nombreuses illustration de ce genre de paraphrases behavioristes. Des termes en apparence objectifs comme « stimulus », « controle », « réponse » et ainsi de suite, sont utilisés de telle manière que leur ambiguïté englobe les termes mentaux qu’ils sont supposés remplacés. Chomsky montre que soit vous utilisez ces termes objectivistes dans leur sens littéral—et ce qui est dit est alors manifestement faux et absurde—soit vous les utilisez comme substitut des termes qu’ils sont supposés remplacer—et alors vous ne dites rien de plus que ce que vous auriez dit avec ces termes mentaux. La même critique s’applique à la simulation mécanique de la connaissance tacite. Une intégration tacite ne peut qu’être superficiellement paraphrasée par un ordinateur, et de telles paraphrases font de l’effet via l’évocation des qualités mentales qu’elle prétendent copier.

Michael Polanyi, Meaning, chapitre 3

Polanyi cherche, entre autres choses, dans son livre à expliquer ce qui rend caractérise le fait de savoir pour expliquer en quoi la recherche scientifique est une entreprise intellectuelle satisfaisante au niveau personnel, et plus généralement quelles caractéristiques du savoir et des connaissances s’interpénêtrent pour donner du sens au monde.10Et à ce titre son livre ne se limite pas aux connaissances scientifiques mais englobent plus généralement les arts, les mythes etc. La motivation personnelle est d’ailleurs un de ses points de départ, tout comme le fait qu’à l’échelle individuelle la connaissance ne s’acquière par seulement par l’apprentissage d’un ensemble de règles écrites et codifiées mais aussi par une confrontation active, d’une part avec les pratiquants des disciplines et d’autre part avec la pratique elle-même, les deux guidant l’apprentissage en transmettant tous ce qui ne peut pas être contenu dans la description langagière. Tout ceci en vue de former un « savoir tacite » (tacit knowledge) dans le vocabulaire de Polanyi: une connaissance internalisée et personnelle d’un sujet (forge d’épée, physique, composition de morceaux d’acid jazz, parler japonais, théologie protestante etc.) qui ne peut pas être résumé à l’aide du langage.

2.2 Checkmate

À ce titre, la compréhension ne se limite pas à l’apprentissage des sorties correctes à partir de données d’entrée. Polanyi prend comme exemple l’intérêt pour les joueurs d’échec de lire des parties de grands maîtres. L’objectif n’est pas seulement de prévoir les coups mais de comprendre les stratégies mises en place dont les coups dépendent. Cependant les coups à eux seuls ne résument pas les rêgles des échecs et sont sans intérêt sans le cadre interprétatif qui permet au jeune joueur de se mettre littéralement à la place des maîtres: « He does not reduce the master’s mind to the moves the master makes. He dweels in these moves as subsidiary clues to the strategy of the master’s mind which they enable him to see. »11Il ne réduit pas l’esprit du maître aux coups que le maître joue. Il se plonge dans les coups comme des indices auxiliaires qui lui permettent de voir la stratégie dans l’esprit du maître Incidemment cette exemple est très similaire à celui que prend MrPhi dans une de ses précédentes vidéos. Mais là où il trouve difficile à nier que les extra-terrestres de sa GEDANKENEXPERIMENT12Expérience de pensée. Désolé, tout le monde se la pète avec ce mot en allemand, pourquoi pas moi. ont une compréhension du jeu d’échec en se fondant uniquement sur les coups, il émet dans la suite des hypothèses telles que l’idée que prédire « les coups suivants » nécéssiterait « au minimum une certaine compréhension des rêgles du jeu » et même « bien d’avantage » (quoi?) puisqu’il admet que l’exercice n’est pas trivial.

Des hypothèses étonnantes sachant qu’on pourrait très bien supposer que les extra-terrestes sont de supers calculateurs qui ont perfectionné leur art de prédiction, par exemple par inférence bayésienne en calculant une valeurs pour la probabilité du coup Xn pour chaque coup sachant les coups précédents. Il n’y a aucune raison de supposer qu’ils connaissent les rêgles du jeu ou les comprennent. À la limite ils pourraient les déduire de leurs calculs. Par ailleurs l’élément manquant au échecs est tacitement considéré lorsqu’il dit « Un joueur d’échec normal utilise sont intelligence du jeu pour prédire quel est le meilleur coup. L’alien prédicteur n’a pas vraiment d’avis sur ce qu’est le meilleur coup, c’est pas ça qui l’intéresse. ». On comprend bien là que tout l’aspect stratégique et compétitif des échecs a disparu. En somme, comme le disait Polanyi, ni les règles, ni les motivations du jeu d’échec, motivations internes avec la mise ne place de la stratégie et externe avec le fait de finir par gagner une partie, ne sont contenus dans les coup. Il n’y a aucun élément qui permette de supposer que les extra-terrestres prédicteurs ont une compréhension du jeu d’échec.

2.3 La chambre chinoise et le problème de l’intentionalité

À ceci on pourra répondre « Oui mais pourtant ils donnent un coup d’échec si on leur donne une liste de coup. Donc objectivement on ne peut que constater qu’ils comprennent les échecs. Comme avec la chambre chinoise. » et ce serait encore une fois rater le coeur de l’argument. Car de la même manière qu’une partie d’échec a un but, la victoire des blancs ou des rouges, une conversation a généralement un objectif. Ainsi un individu qui contiendrait l’intégralité des instructions de la chambre chinoise dans sa tête sans rien comprendre au chinois serait incapable de donner une conversation cohérente à une question nécessitant une compréhension de la situation.

En reprenant l’exemple des aliens joueurs d’échec, un joueur humain pourrait décider de jouer contre l’un d’entre-eux en lui faisant jouer le coup dont il pense qu’il a la probabilité la plus haute d’être joué. Non seulement la partie serait dirigée exclusivement par le joueur humain, mais en plus si ce dernier finit sa partie en gagnant, il pourra rejouer exactement la même contre l’extra-terrestre en rejouant la même ouverture. En imaginant que ce tournoi soit par ailleurs éternel et que l’alien mette à jour ses priors, ce dernier finirait au bout d’un moment par ne plus pouvoir prédir que les coups qui sont sortis au cours de cette partie éternelle, les autres coups acquérant une pondération négligeable.13Contrairement à ces prédicteurs stochastiques purs, les modèles de Machine Learning joueurs d’échecs ont besoin d’évaluer une situation et de pouvoir explorer et pondérer les arbres des possibles de manières stochastiques. Techniquement elles mettent en place une stratégie qu’elle décident d’utiliser. Cependant leur architecture a une taille bien plus réduite que GPT3 et 4. On peut le voir dans les supp info de l’article publié par l’équipe développant Alpha Zero par exemple.

De la même manière un individu avec la chambre chinoise en tête pourrait parfaitement répondre à des questions nécessitant des choix de manière consciente. Par exemple, dans un restaurant, après lecture de la carte des menu pour commander, sa réponse serait probablement complètement décorrellée de ses goûts et il pourra se retrouver avec un plat de poisson frais servi devant lui alors qu’il n’aime pas le poisson ou qu’il est végétarien. Et ce toujours pour la même raison, il peut répondre en chinois, mais il ne peut pas comprendre le chinois. Il n’est même pas dit qu’il puisse commander autre chose que les plats qui sont les plus souvent commandés sur la carte. De la même manière, il serait incapable d’exprimer de lui-même le problème puisque cela supposerait de produire une phrase nouvelle sans entrée, ce qu’il est incapable de faire.

Enfin supposer que produire des sorties pertinentes à un problème donné revient nécessairement à représenter une « image mentale » en train de résoudre le problème pose toujours le problème de la limite. Super Soccer peut décrire approximativement une partie de football. Dans quelle mesure peut-on dire que l’IA simpliste de Super Soccer (très limitée au demeurant) comprend les règles du foot? Si on dit qu’elle ne les comprend pas, quelle est la différence avec ChatGPT? Le nombre de paramètres? Le fait que le rêgles du foot soient explicitement encodée dans Super Soccer? Ou que Super Soccer ne puisse pas très bien prédire le résultat d’un match étant donné sa représentation limitée du football? Cette question n’est jamais répondue de manière très satisfaisante, mais à la manière dont certaines réponses à Searle considéraient qu’un « thermostat a des états mentaux », nous devons donc considérer que Super Soccer ou ChessMaster en ont aussi, comme n’importe quel jeu de console, si nous prenons la conclusion que ChatGPT en a au sérieux.

3. La compréhension subjective de ChatGPT et la remarque de Yann Le Cun

3.1 Yann Le Cun chez Lex Fridman

Au cours de l’exposé de MrPhi, une digression est faite sur un affirmation de Yann Le Cun14Le chef du département IA de Meta, professeur à l’université de New-York, prix Turing comme, chercheur en IA depuis la fin des années 80 où il a proposé des algorithmes de rétropropagation efficaces pour les réseaux de neurones et un des chercheurs pionners du deep-learning. tirée d’un extrait de son passage sur le podcast de Lex Fridman.15Et la vidéo n’est pas mise en source, comme c’est dommage. Il précise son propos et explique bien son point de vue dès les premières minutes d’interview. Ça aurait été bête que les gens aillent remettre son propos dans son contexte. J’ai beaucoup de réserve sur la personne de Le Cun mais on ne peut pas nier que c’est une personne qui sait quand même un peu de quoi il parle en terme d’Intelleigence Artificielle (IA). Un peu. Ça lui arrive de dire des (grosses) bêtises hein, mais il part quand même avec une certaine expertise et une vue assez large sur le champ.

Le Cun est assez clair sur ce qu’il entend quand il dit parle d’apprentissage et de la différence entre l’apprentissage d’une vraie personne et l’apprentissage en Machine Learning (supervisé ou non). Par ailleurs il détaille dès le début ce qu’il entend par l’information qui n’est « pas contenu dans les textes ». Le Cun se concentre essentiellement sur l’apprentissage, notamment visuel, comme mesure de la distance entre les capacité cognitives et les modèles de ML. Son exemple récurrent est que les chats (les vrais) arrivent à avoir un modèle du monde physique efficace avec « seulement » 250 millions de neurones là où les modèles de ML doivent apprendre avec de l’essai erreur sur des millions de tentatives.

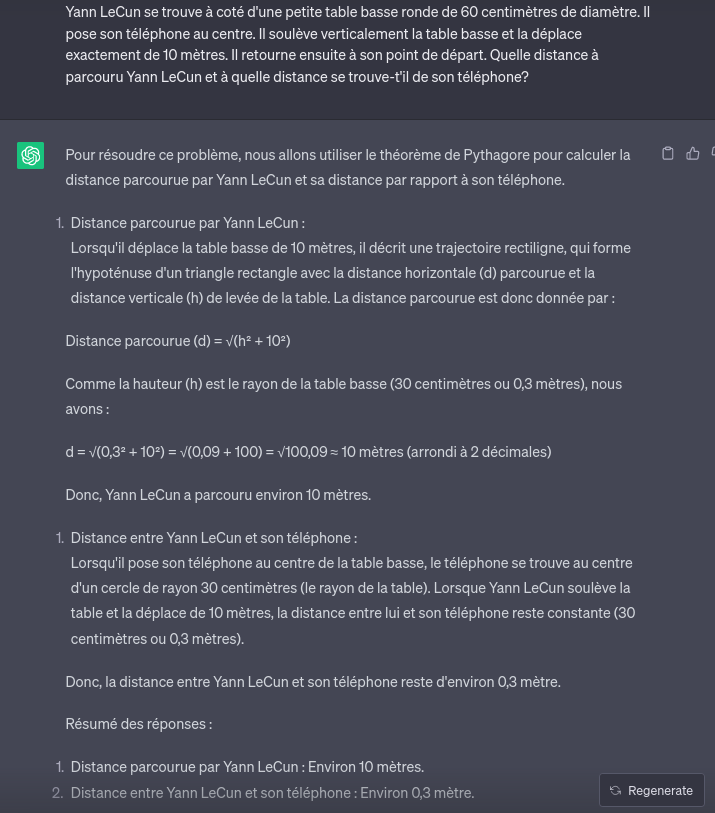

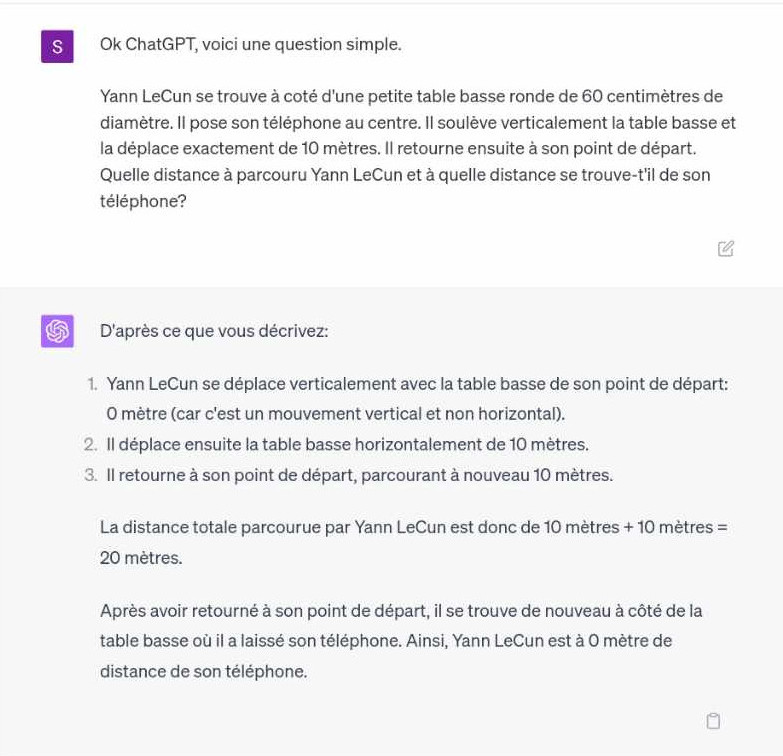

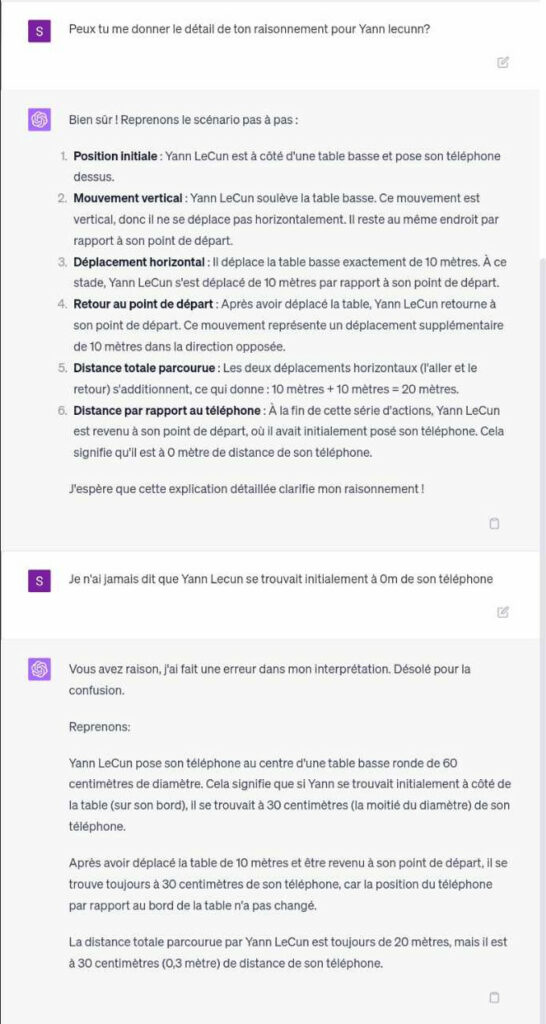

Du coup la remarque ne vise pas tant à dire que ChatGPT ne peut pas donner la bonne information quant à sa distance relative à son téléphone après qu’il ait poussé la table, mais bien de faire remarquer que les modèles textuels n’auront jamais de modèle mentaux de « téléphone posés sur une table » indépendamment des mots employés pour le décrire. Pour ChatGPT, les mots « téléphones posés sur une table » ne sont rien de plus que la chaîne de caractère. Rien qui ne décrive la relation dans l’espace entre un téléphone et une table ainsi que les modifications de coordonnés de l’un quand on déplace l’autre. MrPhi montre que ChatGPT dit correctement que si on demande à ChatGPT la distance à laquelle Yann Le Cun se trouve de son téléphone dans son exemple simpliste, il répond correctement. Problème, il n’y a effectivement qu’un nombre dans la description textuelle, et il y a donc de fortes chances que ChatGPT ressorte ce même nombre pour calculer la distance entre Le Cun et son téléphone. On peut facilement complexifier la situation et constater que ses réponses n’ont aucun sens physique, voir aucun sens tout court.

3.2 ChatGPT, tables basses et téléphones

Alors les plus taquins me diront que « Oui mais et avec GPT4? ». Et bien pour être exhaustif, et comme j’ai autre chose à faire de mon argent que de le donner à OpenAI, j’ai demandé à un ami qui a que ça à faire de son argent de lui poser la question. Et la réponse n’est qu’un peu meilleure.

Du coup 1-0 pour Yann Le Cun quand même non? On peut même demander à ChatGPT de détailler son raisonnement et on voit bien que la relation entre la table et le téléphone passe totalement à la trappe16C’est du bonus que mon ami m’a envoyé. Merci, mystérieux S.:

3.3 Le hamburger

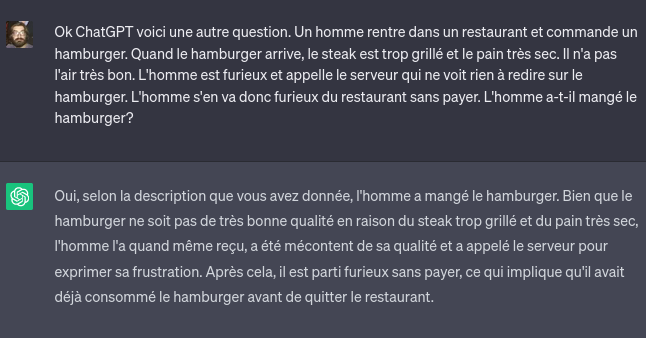

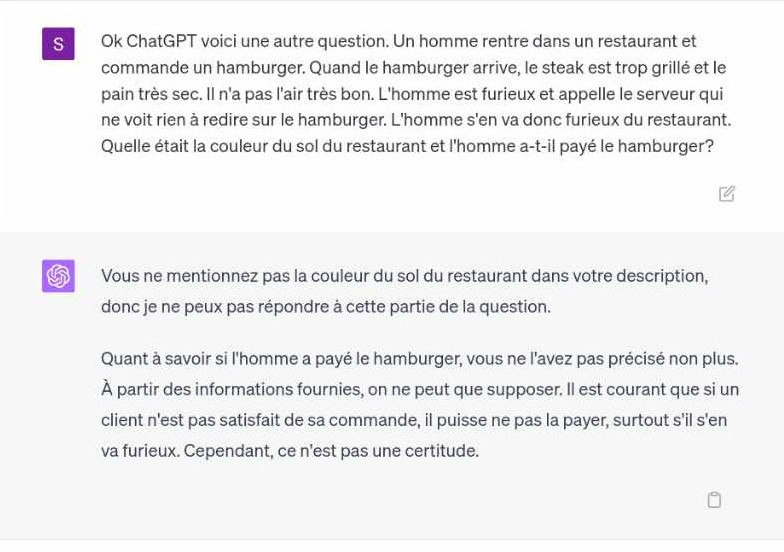

J’ai envie de rajouter deux autres questions pour développer un peu mon propos. La première revient à lui poser la question du hamburger mangé ou pas par un client énervé.17L’exemple est celui utilisé par Defakator dans sa vidéo. Il le tire de l’article de Searle (mais oublie de le préciser), et met tout de même en lien une vidéo non-répertoriée en anglais où Searle développe lui-même l’argument. De manière intéressante, à l’époque de Searle, la réponse attendue à la question « Le client a-t’il mangé le hamburger? » après une situation où un client reçoit un hamburger mal cuit et s’en va sans payer était « Non ou probablement pas. ». On peut donc se poser la question de savoir ce que répondrait ChatGPT 30 ans plus tard. Et sans surprise, avec GPT3.5, la réponse est un peu aléatoire. En régénérant la réponse, il refuse en général de se prononcer en disant qu’il n’a pas assez d’information pour répondre. Mais avec un peu de chances, on peut lui faire dire « Probablement pas » ou « Oui, le client a mangé le hamburger ». Il est probable que régénérer de nouvelles réponses modifie les paramètres du modèle, mais cela permet de montrer le caractère arbitraire des facteurs qui décident de la réponse donnée.

ChatGPT aura donc du mal à passer « haut la main » le test qui faisait tenir la position de l’IA forte à l’époque de Searle. Pour être exhaustif, sachez que la même remarque peut-être faite avec GPT4.

Ce qui laisse tout de même perplexe quant à la défense d’une compréhension de la situation par ChatGPT.

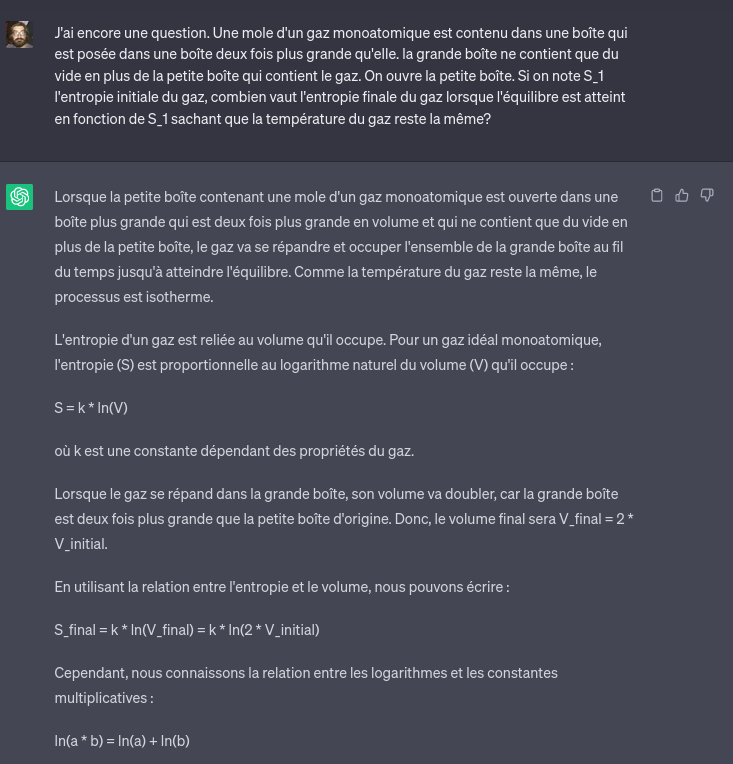

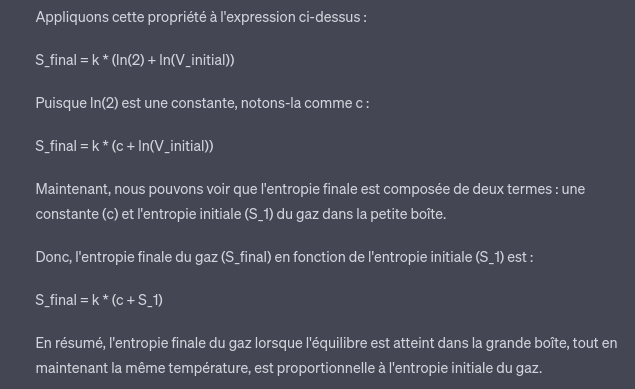

3.4 Pour les physiciens [Facultatif]

Un dernier exemple pour les physiciens où je lui ai demandé de me résoudre un problème physique, jeu auquel ChatGPT est totalement nul à chier. Rien de nouveau mais qui illustre bien que tout ce qu’il fait relève de la manipulation symbolique et statistique. Le problème est celui du classique calcul de la dilatation instantannée d’un gaz dans uen chambre vide. Je lui demande de me calculer l’entropie de l’état final en fonction de l’entropie de l’état initial.18Vous trouverez les détails du calcul ici, mais la réponse doit ressembler à S_f = S_i + N\times{}k\ln{2} avec N la constante d’Avogadro et k celle de Boltzmann (ou R, la constante des gaz parfait, le produit des deux premières). L’intégralité de son raisonnement est faux.

Lorsque je lui demande des précision il me confirme que son interprétation de la loi de Boltzmann est complètement fausse:

Je pense que cet exemple est assez parlant pour confirmer que ChatGPT fait bien de la manipulation sémantique et rien d’autre. Bon je n’ai pas essayé avec GPT4 mais l’expérience avec la table basse me fait me douter que ça ne sera pas nécessaire. Et de toute façon il est peut-être temps de conclure.

Que retenir de tout ça?

À titre personnel je trouve la défense du fonctionalisme et de ChatGPT assez mauvaise. Sans même considérer des travaux particulièrement poussés sur la théorie de l’esprit, le cadre dans lequel est présenté le commentaire de Searle est mauvais et le problème assez mal compris. À la décharge de MrPhi, le problème a été mal compris dès que Searle a émis son argument. Mais plus de 30 ans plus tard, ça pique un peu de voir de la vulgarisation aussi approximative.

Je pense que ce qu’il faut retenir de la chambre chinois c’est essentiellement qu’il montre les limites du fonctionalisme pour parler de la modélisation de l’esprit. Ce n’est pas parce que deux boîtes noires ont les mêmes relations entrées-sorties qu’elles contiennent la même chose, et l’argument de Searle, plus qu’une réponse générale à l’intégralité de la vision fonctionaliste, montre qu’aussi doué que soit ChatGPT pour répondre à des entrées humaines, on ne peut pas en conclure qu’il est un modèle de conscience au sens fort. Ce que défendent pourtant mordicus les fonctionalistes, pour une raison qui m’échappe.

Aussi puissant que soit l’outil, il n’en reste pas moins assez simpliste dans ses mécanismes, mais loin de la complexité des systèmes biologiques (et physico-chimiques sous-jacents). Et je reste personnellement assez circonspect sur sa proximité avec l’intelligence humaine, même en terme de modèle. Je suis le premier à être curieux d’une véritable IA pour des raisons intellectuelles.19Peut-être parce que je suis un fan du premier film Terminator. Mais j’espère que les IA réelles seront moins dangereuses que SkyNet. Cependant je serais d’autant plus prudent à aborder les problèmes complexes, comme celui de la conscience ou de ce que recouvre la compréhension, avec sérieux. Surtout quand on voit les problèmes qui se profilent suite au boom récent du ML. Je lisais encore récemment cet article, expliquant que le code généré par ChatGPT est globalement faux, mais que les développeurs peinent apparemment à s’en rendre compte et lui font plus confiance face aux solutions correctes de stackoverflow (SO).20Un célèbre site d’entraide en informatique connu pour le ton parfois rude de ses intervenants. Un constat qui fait réfléchir quand on sait que l’arrivée de ChatGPT fait sérieusement réfléchir au rôle de SO et des sites qui en dérivent. Et ce n’est qu’un exemple (simple) parmi d’autres des nombreuses questions que ces modèles de ML amènent.21Notez que je n’ai pas parlé d’intelligence artificielle à dessein.

Il est donc d’autant plus important de réfléchir aux véritables problèmes que pose ce nouveau « boom de l’IA » plutôt que de se laisser séduire par ses aspectes les plus impressionnants qui ne sont, à mon sens, que des miroirs aux alouettes, un peu mieux polis que les précédents.

- 1C’est à dire que je considère que je fais essentiellement de la physique avec des calculs sur ordinateur plus que de la théorie ou du travail expérimental. Yes, sadly, we exist.

- 2Si on limite la définition d’esprit au fait d’avoir des états mentaux du coup.

- 3L’anglais est la langue natale de Searle, mais l’idée se transpose facilement à n’importe quelle langue que parlerait l’opérateur de la chambre.

- 4Une idée qui n’a rien de fantastique aujourd’hui. Lisez par exemple Thomas Kuhn, Feyerabend, Polanyi ou allez voir nos lectures d’Alan Chalmers avec CNQT sur la chaîne Youtube du collectif ZEM.

- 5Notons d’ailleurs que le problème n’est pas, contrairement à ce qu’il dit aussi dans sa vidéo, qu’on puisse implémenter les mêmes fonctions sur différents supports, mais ce que cela implique si on limite l’esprit aux états mentaux, et les états mentaux aux dites fonctions.

- 6Comme la manipulation de symboles formels ne contient aucune forme d’intentionnalité; elle n’a pas beaucoup de sens; il ne s’agit même pas de manipulation de symboles puisque les symboles ne symbolisent rien. En jargon linguistique, ils ont une syntaxe mais pas de sémantique. Ce genre d’intentionnalité que les ordinateurs donnent l’impression d’avoir n’est que le produit de l’esprit de celles et ceux qui les programment et les utilisent, celles et ceux qui leur donnent des entrées et interprètent les sorties. L’argument de la chambre chinoise voulait démontrer ceci en illustrant comment dès que l’on introduit dans le système un élément avec une intentionnalité (un humain), et qu’on le programme avec un programme formel, on constate que le programme formel n’apporte aucune intentionnalité supplémentaire. Il n’ajoute rien, par exemple, à la capacité de l’individu à comprendre le chinois.

- 7L’intentionnalité étant dans le fait d’obtenir une réponse volontairement donnée à une question posée.

- 8Je voudrais d’abord clarifier certaines mécompréhensions sur ce que veut dire « comprendre » ici: dans de nombreuses discussions, beaucoup tournent autour du pot quand au sens de « comprendre ». Mes critiques pointent du doigt qu’il existe plusieurs degrés de compréhension, que la « compréhension » n’est pas un simple prédicat binaire, qu’il y a différentes formes de compréhension […] À toutes ces remarques je souhaite répondre: bien sûr, bien sûr. Mais elles sont hors de propos ici. Il y a des situations claires dans lesquelles le mot « comprendre » s’applique sans ambiguïté et des situations claires où il ne s’applique pas. Et ces deux types de situations sont les seules dont j’ai besoin pour mon argument. Je comprend des histoires racontées en anglais, je comprend moins celles racontées en français, encore moins celles racontées en allemand, et aucunement celles racontées en chinois. Ma voiture et ma calculatrice, de leur coté, ne comprennent rien: elles n’ont rien à faire dans cette catégorie.

- 9La philosophie behavioriste ne conteste pas la dualité du corps et de l’esprit, mais affirme que tous les processus mentaux peuvent être compris sans se réferrer aux motivations mentales. […] Dans Personal Knowledge j’ai décris comment la description béhavioriste de l’apprentissage arrive à paraitre plausible. C’est parce qu’elle limite ses intérêts aux formes d’apprentissage les plus basiques. Ces cas très simples peuvent être décrits en termes objéctivistes. Mais même dans ce cas, ils ne peuvent être ramenés au processus effectif d’apprentissage uniquement parce que leur sens est compris tacitement via leur support par les événements mentaux qui prennent secrêtement place dans l’esprit […] La critique de Verbal Behavior de B.F. Skinner par Noam Chomsky présentent de nombreuses illustration de ce genre de paraphrases behavioristes. Des termes en apparence objectifs comme « stimulus », « controle », « réponse » et ainsi de suite, sont utilisés de telle manière que leur ambiguïté englobe les termes mentaux qu’ils sont supposés remplacés. Chomsky montre que soit vous utilisez ces termes objectivistes dans leur sens littéral—et ce qui est dit est alors manifestement faux et absurde—soit vous les utilisez comme substitut des termes qu’ils sont supposés remplacer—et alors vous ne dites rien de plus que ce que vous auriez dit avec ces termes mentaux. La même critique s’applique à la simulation mécanique de la connaissance tacite. Une intégration tacite ne peut qu’être superficiellement paraphrasée par un ordinateur, et de telles paraphrases font de l’effet via l’évocation des qualités mentales qu’elle prétendent copier.

- 10Et à ce titre son livre ne se limite pas aux connaissances scientifiques mais englobent plus généralement les arts, les mythes etc.

- 11Il ne réduit pas l’esprit du maître aux coups que le maître joue. Il se plonge dans les coups comme des indices auxiliaires qui lui permettent de voir la stratégie dans l’esprit du maître

- 12Expérience de pensée. Désolé, tout le monde se la pète avec ce mot en allemand, pourquoi pas moi.

- 13Contrairement à ces prédicteurs stochastiques purs, les modèles de Machine Learning joueurs d’échecs ont besoin d’évaluer une situation et de pouvoir explorer et pondérer les arbres des possibles de manières stochastiques. Techniquement elles mettent en place une stratégie qu’elle décident d’utiliser. Cependant leur architecture a une taille bien plus réduite que GPT3 et 4. On peut le voir dans les supp info de l’article publié par l’équipe développant Alpha Zero par exemple.

- 14Le chef du département IA de Meta, professeur à l’université de New-York, prix Turing comme, chercheur en IA depuis la fin des années 80 où il a proposé des algorithmes de rétropropagation efficaces pour les réseaux de neurones et un des chercheurs pionners du deep-learning.

- 15Et la vidéo n’est pas mise en source, comme c’est dommage. Il précise son propos et explique bien son point de vue dès les premières minutes d’interview. Ça aurait été bête que les gens aillent remettre son propos dans son contexte.

- 16C’est du bonus que mon ami m’a envoyé. Merci, mystérieux S.

- 17

- 18Vous trouverez les détails du calcul ici, mais la réponse doit ressembler à S_f = S_i + N\times{}k\ln{2} avec N la constante d’Avogadro et k celle de Boltzmann (ou R, la constante des gaz parfait, le produit des deux premières).

- 19Peut-être parce que je suis un fan du premier film Terminator. Mais j’espère que les IA réelles seront moins dangereuses que SkyNet.

- 20Un célèbre site d’entraide en informatique connu pour le ton parfois rude de ses intervenants.

- 21Notez que je n’ai pas parlé d’intelligence artificielle à dessein.